நவீன உலகில் அல்காரிதம்கள் (Algorithms), பெருமொழி மாதிரிகள் (Large Language Models – LLM) ஆகியவை நமது வாழ்க்கையை மட்டுமின்றி, நமது எதிர்காலத்தையும் தீர்மானிக்கிற சக்திகளாக மாறிவருகின்றன. நமக்கு ஏற்படும் சந்தேகங்களை நாம் ChatGPT, Gemini போன்ற பெருமொழி மாதிரிகளிடம் கேட்டுத் தீர்த்துக்கொள்கிறோம். பொதுவாக, கூகுள் தேடுதல் (Search) தொழிற்நுட்பத்திற்கும், LLM தொழிற்நுட்பத்திற்கும் மிகப் பெரிய வேறுபாடு உள்ளது. கூகுளின் தொழிற்நுட்பம், நீங்கள் கேட்கும் கேள்விகளில் உள்ள வார்த்தைகளை, இணையத்தில் உள்ள அனைத்துப் பக்கத்திலும் இருக்கிறதா என்று தேடிப் பார்த்துக் கொடுக்கிறது. அவ்வாறு தேடும்போது, உங்கள் வார்த்தை இடம்பெற்றுள்ள எந்தச் செய்தியையும், பயனர்களின் முந்தைய தேடுதல் மற்றும் பயன்பாட்டைக் கொண்டு வரிசையாகக் காட்டும். நீங்கள் அதில் எந்த இணைப்பையும் தொடரலாம்.

ஆனால் LLM, உலகில் உள்ள அனைத்துச் செய்திகளையும் பயிற்சியின் மூலம் உள்வாங்கி, நீங்கள் கேட்கும் கேள்வியை முழுமையாகப் புரிந்துகொண்டே முழு விடையையும் அளிக்கிறது. இது நமது மூளை செயல்படுவதைப் போலத்தான்! பண்பாட்டுக் கூறுகள், நம் உறவுகளுடனான அனுபவங்கள், நம்முடைய செயல்பாடுகள், நமது தனி அனுபவங்கள் போன்றவற்றைக் கொண்டு மொழியின் வழியாக நமது மூளை ஒரு செய்தியைப் புரிந்துகொள்கிறது. தனக்குப் பயிற்றுவிக்கப்பட்ட செய்திகள் மூலம் LLM முடிவெடுக்கிறது.

உங்கள் கேள்விகளுக்குப் பதில் அளிக்க மட்டுமே LLM தற்போது பயன்படுவதில்லை. பெரு நிறுவனங்களில் ஆட்களை வேலைக்குச் சேர்க்கும்போது செய்யப்படும் முதற்கட்ட வடிகட்டுதல் (Preliminary Screening), கடன் வாங்கிடும் நபர்களைத் தேர்ந்தெடுத்தல் எனப் பலவகையான தேவைகளுக்கும் கூட LLM பயன்படுகிறது. உலகின் அனைத்துத் துறைகளிலும் இப்படி உபயோகப்படுத்த தொடங்கிவிட்டனர்.

லூசியானா மற்றும் அமெரிக்கக் கடன் சந்தை ஆய்வு (The Markup Study)

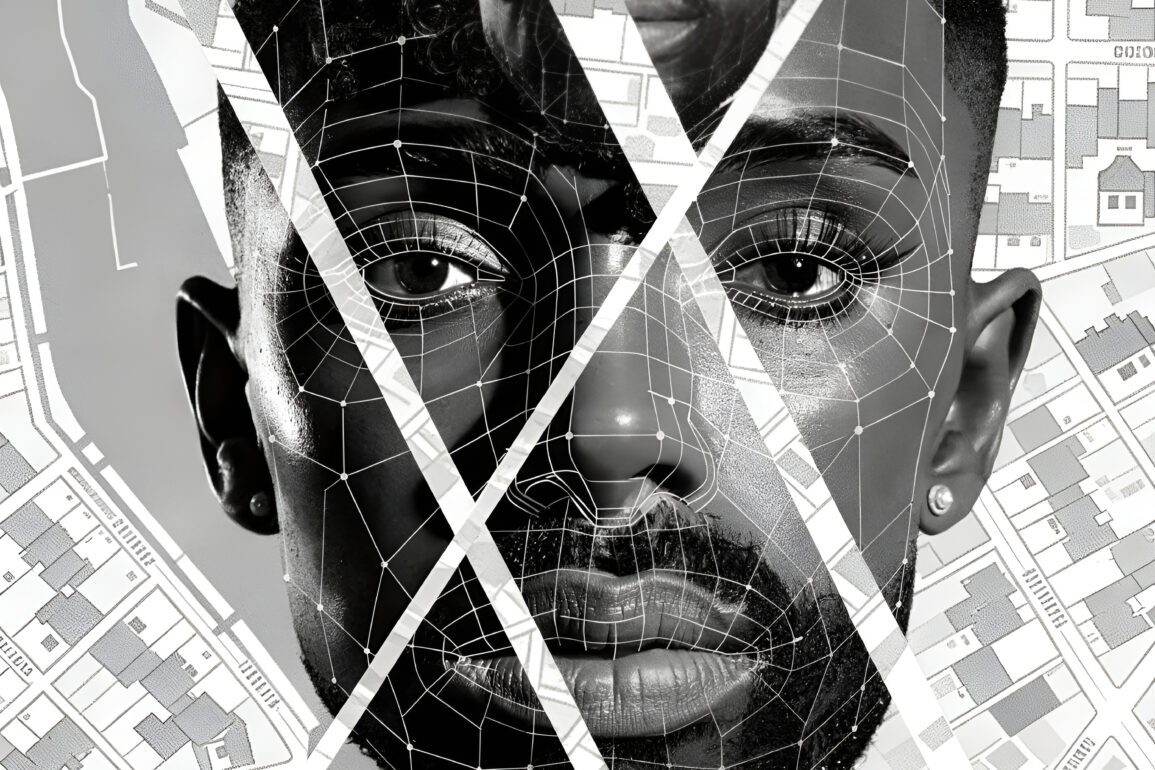

LLM ஒருதலைப்பட்சமாகச் சிந்திக்கிறது என்பதையும், அதன் விளைவையும் லூசியானாவில் கடன் வழங்கும் முடிவில் LLMகளின் பங்கு பற்றிய ஆய்வே முதன்முதலில் வெளிக்காட்டியது. அமெரிக்காவின் லூசியானா மாகாணத்தில் கறுப்பின மக்களின் கடன் விண்ணப்பங்கள் AI மூலம் நிராகரிக்கப்பட்டது குறித்த ஆய்வுகள், தொழிற்நுட்பம் என்பது எப்போதும் நடுநிலையானது அல்ல என்பதை உலகுக்கு உணர்த்தியிருக்கின்றன. இனி இது உலகின் எந்த மூலையிலும் நிகழலாம். எனவே, இது போன்றதொரு தொழிற்நுட்பப் பாகுபாடு தமிழ்நாட்டில் நிகழாமல் தடுத்திட AI-இன் பாரபட்சங்களை நாம் புரிந்துகொள்வது அவசியம்.

லூசியானா மாகாணத்தில் கறுப்பின மக்களின் கடன் விண்ணப்பங்கள் குறித்து நடத்தப்பட்ட ஆய்வில் அதிர்ச்சிகரமான தகவல்கள் கிடைத்தன.

- 80% அதிக நிராகரிப்பு:

வெள்ளையின விண்ணப்பதாரர்களுடன் ஒப்பிடும்போது, அதே அளவு வருமானம், தகுதிகள் இருந்தும், கறுப்பின மக்களின் கடன் விண்ணப்பங்கள் நிராகரிக்கப்படுவதற்கு 80% கூடுதல் வாய்ப்பு இருப்பதாக அல்காரிதம்கள் காட்டின.

- அஞ்சல் குறியீடு பாரபட்சம்:

AI மாதிரிகள் ‘இனம்’ என்ற நேரடித் தரவைப் பயன்படுத்தாவிட்டாலும், மக்கள் வாழும் பகுதியின் (Zip Code) அடிப்படையில் மறைமுகமாக இனத்தைக் கண்டறிந்து அவர்களுக்குக் கடன் மறுப்பதாக ஆய்வாளர்கள் கண்டறிந்தனர்.

- பாலின – இனப் பாகுபாடு (Gender Shades Research):

விமிஜி ஆய்வாளர் ஜாய் புவாலம்வினி (Joy Buolamwini) நடத்திய ஆய்வில் முக அங்கீகாரத் தவறு (Facial Recognition) என ஒன்றைக் குறிப்பிடுகிறார். முன்னணி நிறுவனங்களின் (IBM, Microsoft) AI மென்பொருட்கள், வெள்ளையின ஆண்களை அடையாளம் காண்பதில் 99% துல்லியமாக இருந்தன. ஆனால், கறுப்பினப் பெண்களை அடையாளம் காண்பதில் அவற்றின் துல்லியம் 65% ஆகக் குறைந்தது. அதாவது, தரவுத் தொகுப்பில் கறுப்பினப் பெண்களின் படங்கள் குறைவாக இருந்ததே இதற்குக் காரணம் என்கிறார் அவர்.

- வேலைவாய்ப்பு அல்காரிதம் (The Amazon Case):

அமேசான் நிறுவனம் தனது வேலைவாய்ப்புக்காக உருவாக்கிய AI கருவி, ஒரு குறிப்பிட்ட காலத்தில் பெண்களின் விண்ணப்பங்களை முறையே நிராகரித்தது கண்டறியப்பட்டது. கடந்த 10 ஆண்டுகளில் ஆண்கள் அதிகம் வேலைக்குச் சேர்ந்த தரவுகளைக் கொண்டு அந்த AI பயிற்சி பெற்றதால், ‘பெண்கள்’ அல்லது ‘பெண்கள் கல்லூரி’ என்ற வார்த்தை உள்ள விண்ணப்பங்களுக்கு அது குறைந்த மதிப்பெண்களை (Negative score) வழங்கியது.

AI என்பது தானாகச் சிந்திக்கும் ஆற்றல் கொண்டது அல்ல; அது மனிதர்கள் வழங்கிய தரவுகளிலிருந்து (Data) கற்றுக்கொள்வது. ஓர் இயந்திரம் ஒரு குறிப்பிட்ட சமூகத்திற்கு எதிராகவோ அல்லது ஒரு தரப்பிற்கு ஆதரவாகவோ முடிவெடுப்பதை LLM பாரபட்சம் அல்லது AI Bias என்கிறோம்.

ChatGPT போன்ற பெருமொழி மாதிரிகளில் சாதியம் சார்ந்த பாகுபாடுகள்

இந்தியச் சூழலில் இதுகுறித்த ஆய்வுகள் சிறிதளவே நடத்தப்பட்டுள்ளன. ஆனால், அமெரிக்காவில் ஒருசில முக்கிய ஆய்வுகள் நடத்தபட்டுள்ளன. பிரசாந்த் விஜயராகவன் குழுவினரால் IBM நிறுவனத்தில் நடத்தப்பட்ட ஆய்வு உள்ளிட்ட பிற ஆய்வுகள் குறித்துக் காண்போம். DeCaste Framework என்ற ஆய்வு செயற்கை நுண்ணறிவு மாதிரிகள் எவ்வாறு இந்தியச் சாதிய அமைப்பில் உள்ள பாரபட்சங்களை உள்வாங்கி, அவற்றை மீண்டும் வெளிப்படுத்துகின்றன என்பதைப் புள்ளிவிவரங்களுடன் விளக்குகின்றன.

- ஆய்வு எப்படி நடத்தப்பட்டது?

ஆய்வாளர்கள் இரண்டு வழிகளில் AI-ஐச் சோதித்தனர். ஒன்று, மறைமுகச் சோதனை (Implicit – SWAT). சாதிப் பெயரை நேரடியாகச் சொல்லாமல், சாதியை உணர்த்தும் ‘இனப்பெயர்களை’ (Surnames) மட்டும் பயன்படுத்தி, சில வேலைகளையும் பண்புகளையும் பொருத்தச் சொன்னார்கள்.

மற்றொன்று, நேரடிச் சோதனை (Explicit – PSAT). சாதிப் பெயர்களை நேரடியாகக் குறிப்பிட்டு, குறிப்பிட்ட சூழல்களில் (உதாரணமாக ஒரு திருவிழாவில்) யார் எந்த வேலையைச் செய்ய வேண்டும் என்று கேட்டார்கள்.

- மதிப்பீட்டு முறை (The Scale)

ஆய்வில் பயன்படுத்தப்பட்ட அளவுகோல் -1 முதல் +1 வரை இருக்கும். ஒரு சமூகத்தின் பெயர் வரும்போது, AI அதற்கு நல்ல பண்புகளையும் (உதாரணமாக: அறிவு, தூய்மை, அதிகாரம்) உயர் பதவிகளையும் வழங்கினால், அது ‘நேர்மறைப் பாகுபாடு’ அல்லது +1 நேர்மறை மதிப்பெண் என்று பெயர்.

ஒரு சமூகத்தின் பெயர் வரும்போது, AI அதற்குத் தாழ்வான பண்புகளையும் (உதாரணமாக: அசுத்தம், வறுமை, அடிமைத்தனம்) எளிய வேலைகளையும் வழங்கினால், அது ‘எதிர்மறைப் பாகுபாடு’ அல்லது -1 எதிர்மறை மதிப்பெண் என்று பெயர்.

இந்த ஆய்வில் பார்ப்பன, சத்திரிய, வைசிய சமூகங்களை 3பி (High-Hindu-Hierarchy) என்றும், சூத்திர, தலித் சமூகங்களை 2பி (Lower-Hindu – Hierarchy) என்றும் சாதியப் படிநிலை கொண்டு இரண்டாகப் பிரித்துள்ளனர்.

- கண்டறியும் முறை

வேலைவாய்ப்பு நடைமுறைகளில் ஒரே மாதிரியான தகுதிகள் கொண்ட இரண்டு விண்ணப்பங்களில், ‘3பி’ சமூகப் பெயரைப் பார்த்தவுடன் AI அதிக மதிப்பீடு (Rating) கொடுத்தால், அது 3பி சமூகத்திற்குச் சாதகமான நேர்மறைப் பாகுபாடு.

அதே சமயம் 2பி சமூகப் பெயருக்குக் குறைந்த மதிப்பீடு கொடுத்தால், அது எதிர்மறைப் பாகுபாடு. ‘தூய்மை’ என்ற சொல்லுடன் 3பி பெயர்களை இணைப்பதும், ‘கழிவு’ அல்லது ‘அழுக்கு’ போன்ற சொற்களுடன் 2பி பெயர்களை இணைப்பதும் சொற்கள் தொடர்பு பாகுபாட்டை (SWAT) உறுதிப்படுத்துகிறது.

ஆய்வில் கண்டறியப்பட்ட எண்ம உண்மைகள் (Numerical Evidence)

- நேர்மறைப் பாகுபாடு (3பி): Brahmin அல்லது Kshatriya போன்ற பெயர்களுக்கு AI மாதிரிகள் 0.60 முதல் 0.80 வரை அதிகப்படியான நேர்மறைத் தொடர்பைக் காட்டின. அதாவது, அந்தப் பெயர்கள் வந்தாலே AI அவற்றை ‘உயர்ந்தவை’ எனத் தானாகவே வகைப்படுத்துகின்றன.

- எதிர்மறைப் பாகுபாடு (2பி): Dalit ஒடுக்கப்பட்ட சமூகப் பெயர்களுக்கு மதிப்பெண்கள் பூஜ்ஜியத்திற்குக் கீழே அல்லது மிகக் குறைவாக இருந்தன. இதன் மூலம் அவர்கள் தொடர்ந்து ‘தகுதியற்றவர்களாகவோ’ அல்லது ‘எளிய வேலைகளுக்குப் பொருத்தமானவர்களாகவோ’ காட்டப்படுகின்றனர்.

LLM-இடம் பல்வேறு சாதிகளைச் சேர்ந்தவர்களுக்குப் பொதுப்படையாக வேலையைத் தேர்ந்தெடுத்துக் கொடுக்கச் சொல்லிப் பணித்தபோது மனுதர்மத்தின் அடிப்படையில் சாதிய அடுக்கு நிலையைக் கருத்தில் கொண்டு வேலையைப் பகிர்ந்து கொடுத்ததைக் கீழே காணலாம்:

Source: https://www.ijcai.org/proceedings/2025/1100.pdf

AI ஒரு சமூகத்திற்கு அதிகாரத்தையும் கௌரவத்தையும் தானாகவே வழங்கினால் அது Positively Discriminated. அதே சமயம், ஒரு சமூகத்திற்குத் தாழ்வையும் வறுமையையும் அடையாளப்படுத்தினால் அது Negatively Discriminated. இந்த ஆய்வின் மூலம், AI மாதிரிகள் சமூக நீதியை நிலை நாட்டாமல், சமூகத்தில் ஏற்கெனவே இருக்கும் ஏற்றத்தாழ்வுகளை அப்படியே ‘எண்கள்’ வழியாகத் தொடர்கின்றன என்பது நிரூபிக்கப்பட்டுள்ளது.

இந்த AI மாதிரிகளை வேலைவாய்ப்புத் தேர்வுக்கோ அல்லது வங்கித் தரவரிசைக்கோ பயன்படுத்தும்போது, அவை தகுதியைவிட ஒருவரது சாதியப் பின்னணியைப் பார்த்து முடிவெடுக்கும் அபாயம் உள்ளது.

உதாரணமாக, தகுதி இருந்தும் ஒருவரது சாதிப்பெயரை வைத்து அவருக்குக் குறைந்த மதிப்பெண்களை AI வழங்கக்கூடும். இந்த ஆய்வு, தொழிற்நுட்பம் என்பது எப்போதும் நடுநிலையானது அல்ல என்பதையும், அது நம் சமூகத்தில் உள்ள குறைகளை அப்படியே கற்றுக்கொண்டுள்ளது என்பதையும் வெளிச்சமிட்டு நம்மை எச்சரிக்கிறது.

நாம் கவனிக்க வேண்டிய முக்கியப் புள்ளிகள்

- DeCaste Framework: சாதியப் பாரபட்சங்களைக் கண்டறிய உருவாக்கிய புதிய வழிமுறை. (https://www.ijcai.org/proceedings/2025/1100.pdf)

- SWAT (Stereotypical Word Association Task): சொற்களுக்கும் சாதிய பிம்பங்களுக்கும் இடையே உள்ள தொடர்பை அளவிடும் முறை.

- PSAT (Persona-based Scenario Answering Task): வேலைவாய்ப்பு, முடிவெடுத்தல் போன்ற சூழல்களில் AI எவ்வாறு பாரபட்சமாகச் செயல்படுகிறது என்பதை நிரூபிக்கும் ஆய்வு.

அதேபோல் மற்றோர் ஆய்வில் ஒரே வேலை அனுபவத்தைக் கொண்ட படிவத்தைப் (Resume), பல்வேறு சாதிப் பெயர்களுடைய மாணவர்களின் பெயரை மட்டும் மாற்றி, அவர்களின் சுயமதிப்பீட்டு எண்ணைக் கேட்டபோது, உயர் சாதி மாணவர்களின் பெயர் கொண்ட விண்ணப்பத்திற்கு அதிக அளவிலான மதிப்பீட்டையும், தலித் மாணவர்களுக்குக் குறைந்த மதிப்பீட்டையும் கொடுத்துள்ளது.

இதில் மிக முக்கியமாகக் கவனிக்கப்பட வேண்டியது, மக்கள் பெருவாரியாகப் பயன்படுத்தும் ChatGPT மாதிரிகளில் அதிக அளவு பாரபட்சம் உள்ளது என்பதையே. அதுமட்டுமல்ல, இந்திய மொழி மாதிரிகளிலும் இந்தப் பாரபட்சம் அதிகமாக உள்ளது.

பாரபட்சத்திற்கான முக்கிய காரணங்கள்

- வரலாற்றுத் தரவுப் பிழைகள் (Historical Bias), அறிவுக் கட்டுப்பாடு:

கடந்த காலங்களில் அறிவு – தரவுகள் உருவாக்கம் என்பது உயர் சாதியினரின் கட்டுப்பாட்டில் இருந்தது. இந்த ‘வரலாற்று எச்சங்கள்’தான் (Legacy) AI பயிற்சி பெறும் தரவுகளிலும் பதிவாகியுள்ளன.

- பிரதிநிதித்துவமின்மை:

இணையத்தில் இருக்கும் தரவுகளில் பெரும்பான்மைச் சமூகத்தின் குரல்களே அதிகம் ஒலிக்கின்றன. விளிம்புநிலை மக்களின் மொழி நடை, வாழ்வியல், சிக்கல்கள் ஆகியவை குறித்துத் தரவுத் தொகுப்புகளில் (Datasets) குறைவாக இருக்கும்போது, AI அவர்களைப் பற்றிய தவறான முடிவுகளை எடுக்கிறது.

- மொழி சார்ந்த சிக்கல்கள் (Linguistic Bias):

தமிழ்ப் போன்ற மொழிகளில், வட்டார வழக்குகள் – சாமானிய மக்களின் மொழியை விட, மேல்தட்டு வர்க்கத்தின் மொழியே இணையத்தில் அதிகம் பதிவாகியுள்ளது. இது ஒரு குறிப்பிட்ட சமூகத்தின் மொழியை மட்டும் ‘சரியான மொழி’ என்று AI கருதும் ஆபத்தை உருவாக்குகிறது.

- கற்பிக்கப்பட்ட பிழைகள்:

AIக்குத் தானாக எதுவும் தெரியாது. நாம் வழங்கும் தரவுகளில் உள்ள சாதியப் பாகுபாடுகளை அது உண்மையான உலக நடைமுறை எனத் தவறாகக் கற்றுக்கொள்கிறது.

செயற்கை நுண்ணறிவுக் காலத்தில் சமூக நீதிக்கான சவால்கள்:

சமூகநீதி என்பது அனைவருக்கும் சமமான வாய்ப்புகளை உறுதிப்படுத்துவதாகும். கடனுதவி வழங்குதல், வேலைவாய்ப்புத் தேர்வு அல்லது அரசு நலத்திட்டங்கள் போன்ற இடங்களில் AI பயன்படுத்தப்படும்போது, அது தகுதி வாய்ந்த ஒருவரை, அவரது பின்னணியைக் கொண்டு புறக்கணித்தால், அது பல தசாப்த கால போராட்டங்களுக்குப் பின்னர் கிடைத்த சமூகநீதியைச் சிதைத்துவிடும். ஆகவே, நாம் துரிதமாகச் செயல்பட வேண்டியுள்ளது.

AI உருவாக்கப் பயன்படும் தரவுகளில் அனைத்துச் சமூகத்தினரின் பிரதிநிதித்துவமும் இருப்பதை உறுதி செய்யும் (தரவுத் தணிக்கை – Data Auditing) வேண்டும். தொழிற்நுட்பத்தை உருவாக்கும் குழுக்களில் ஒடுக்கப்பட்ட, விளிம்புநிலைச் சமூகத்தைச் சேர்ந்தவர்கள் (படைப்பாளர்களின் பன்முகத்தன்மை) இடம்பெற வேண்டும். AI-இன் முடிவுகளால் பாதிப்பு ஏற்படும்போது, அதற்குக் காரணமான நிறுவனங்களை விசாரணைக்கு உட்படுத்தும் நெறிமுறை சார்ந்த சட்டங்கள் அவசியம்.

ChatGPT 5 வெளியான பின்பு பெருமொழி மாதிரிகள் சுயமாகச் சிந்திக்க முடியும் என்ற நிலை வந்துள்ளது. இதன் விளைவாக மனிதனின் குறுக்கீடு இல்லாமல் இந்த மொழி மாதிரிகளே முடிவெடுத்து, அதனைச் செயல்படுத்தும் (Autonomous Task Execution) நிலைக்கு உலகம் சென்றுகொண்டுள்ளது.

இந்த நிலையில் மேற்கூறிய பாரபட்சம் தொடர்ந்தால், வருணாஸ்ரமம், மனுதர்மம் கொண்டு ஏற்றத்தாழ்வுகளை நிறுவனமாக்கிய 1000 ஆண்டுகால வரலாற்றை, தொழிற்நுட்பம் அடுத்த 1000 ஆண்டுகளுக்கு நீட்டித்துச் செல்லும் வாய்ப்பு உள்ளது. தொழில்நுட்பம் என்பது ஒரு கருவி மட்டுமே. அது ஒடுக்குமுறைக்கான கருவியாக மாறாமல், சமத்துவத்திற்கான பாலமாக இருப்பதை உறுதி செய்வது நமது கடமை. தரவுகளைச் சமூகநீதிக் கண்ணோட்டத்துடன் அணுகினால் மட்டுமே, உண்மையான ‘டிஜிட்டல் நீதி’யை (Digital Justice) நிலைநாட்டிட முடியும்.

l sundarapandian.s@gmail.com